英伟达今晨在刚刚开幕的GTC 2024主题演讲上正式发布了全新的NVIDIA Blackwell平台,为计算的新时代提供动力,使世界各地的组织能够在万亿参数大型语言模型上构建和运行实时生成式AI,Blackwell GPU架构采用六项用于加速计算的变革性技术,成本和能耗比上代至高可以降低25倍。

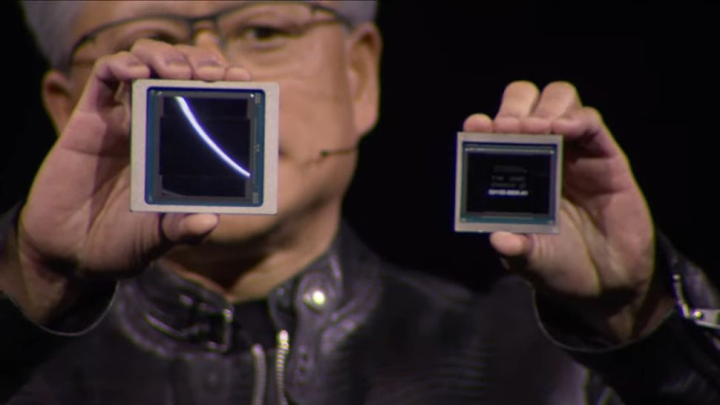

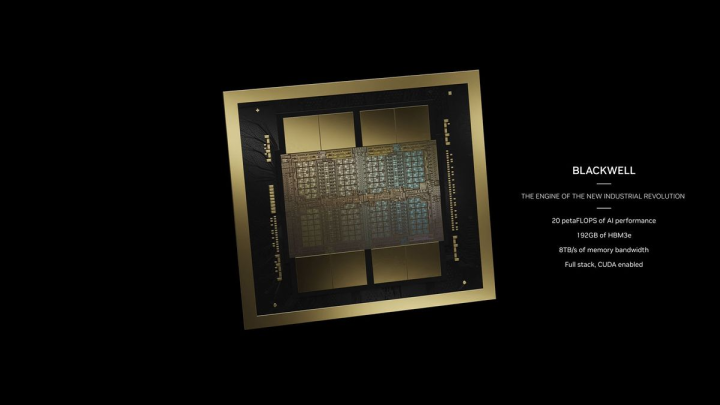

全新的Blackwell GPU体积庞大,采用台积电的4纳米(4NP)工艺制造而,由两个达到视网膜上线大小的芯片组合而成,共有2080亿个晶体管,然后通过高达10TB/秒的芯片到芯片链路连接成为一个GPU芯片。

黄仁勋表示,Blackwell架构GPU的AI性能可达20petaflops,而上代H100的性能仅有4petaflops。此外,每个Blackwell Die的浮点运算能力要比Hopper Die高出25%,而且每个封装中有两个Blackwell芯片,总性能提高了2.5倍。如果处理FP4八精度浮点运算,性能还能提高到5倍。取决于各种Blackwell设备的内存容量和带宽配置,工作负载的实际性能可能会更高。此外,此前训练一个1.8万亿个参数的模型以前需要8000个Hopper GPU和15兆瓦的电力,目前则仅需2000个Blackwell GPU就能完成这项工作,耗电量仅为4兆瓦。

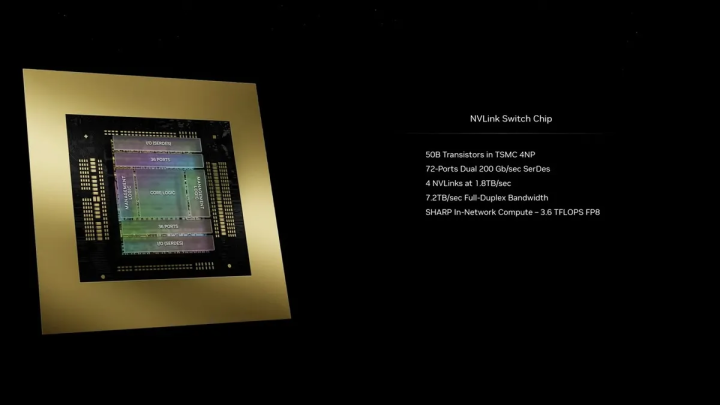

此外,全新的Blackwell架构还配备第二代Transformer引擎,支持双倍的计算和模型大小;升级第五代NVLink,为每个GPU提供突破性的1.8TB/s双向吞吐量,确保多达576个GPU之间为最复杂的LLM提供无缝高速通信;配备RAS引擎用于实现可靠性、可用性和可维护性;配备安全AI,可在不影响性能的情况下保护AI模型和客户数据,并支持新的本机接口加密协议;还支持最新格式解压缩引擎,可加速数据库查询,从而在数据分析和数据科学领域提供最高性能。

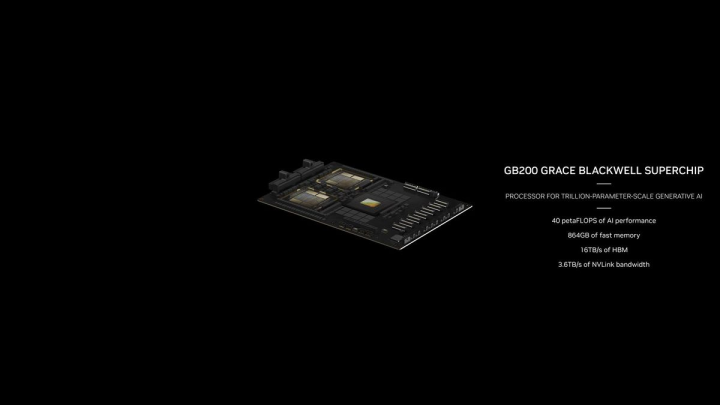

而全新的NVIDIA GB200 Grace Blackwell超级芯片包含了两个B200 Blackwell GPU和一个基于Arm的Grace CPU,通过900GB/s超低功耗NVLink芯片到芯片互连将两个NVIDIA B200 Tensor Core GPU连接到NVIDIA Grace CPU。在参数为1,750亿的GPT-3LLM基准测试中,英伟达称GB200的性能是H100的7倍,而训练速度是H100的4倍。

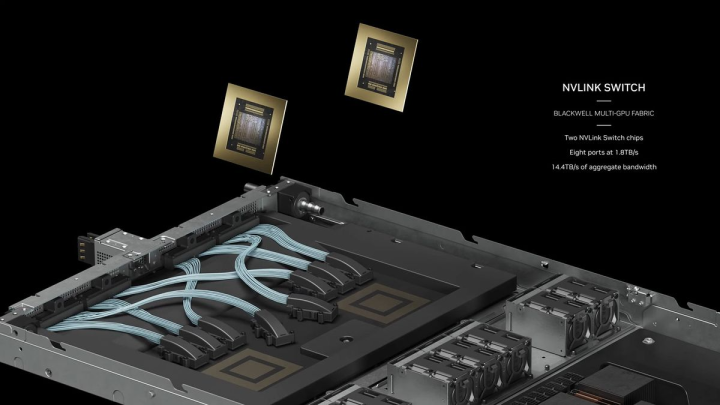

英伟达还面向有大型需求的企业提供成品服务,提供完整的服务器出货,例如GB200NVL72服务器,提供了36个CPU和72个Blackwell GPU,并完善提供一体水冷散热方案,可实现总计720petaflops的AI训练性能或1440petaflops(1.4exaflops)的推理性能。它内部使用电缆长度累计接近2英里,共有5000条独立电缆。

机架上的每个托盘包含两个GB200芯片或两个NVLink交换机,每个机架有18个GB200芯片和9个NVLink交换机,英伟达称,一个机架总共可支持27万亿个参数模型。而作为对比,GPT-4的参数模型约为1.7万亿。英伟达称,其系统可扩展至数万GB200超级芯片,并通过全新的Quantum-X800 InfiniBand(最多144个连接)或Spectrum-X800以太网(最多64个连接)与800Gbps网络进行连接。

企业中心>

服务器>

企业中心>

服务器>